400-123-4567

13988999988

公司地址:广东省广州市天河区88号

联系方式:400-123-4567

公司传真:+86-123-4567

手机:13988999988

论文题目:Cognitive Behaviors that Enable Self-Improving Reasoners, or, Four Habits of Highly Effective STaRs论文链接:https://arxiv.org/abs/2503.01307这项研讨一宣布就引来浩繁探讨,比方 Synth Labs CEO 以为这个发明十分冲动民气,由于其可被整合进任何模子中!

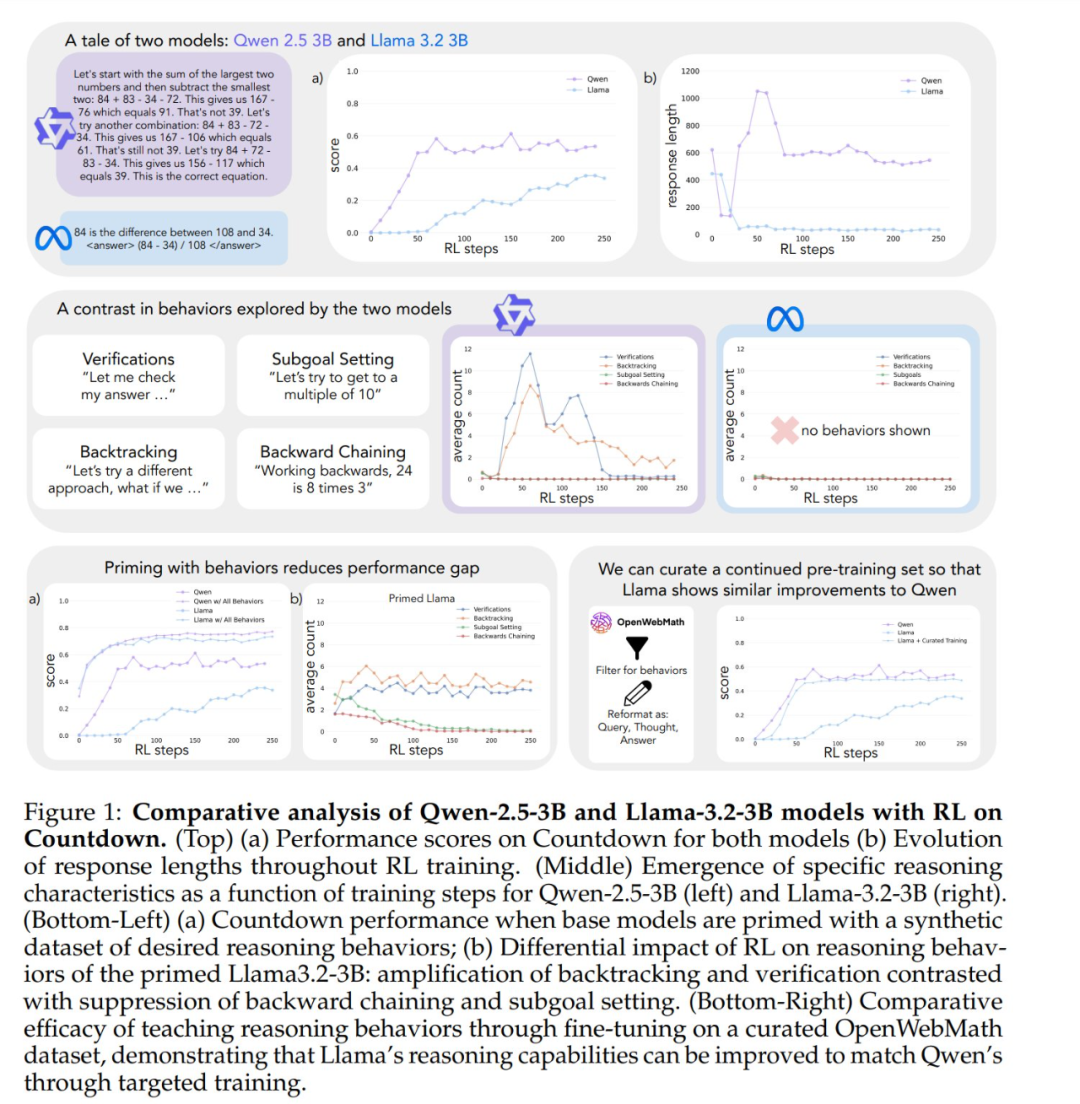

论文题目:Cognitive Behaviors that Enable Self-Improving Reasoners, or, Four Habits of Highly Effective STaRs论文链接:https://arxiv.org/abs/2503.01307这项研讨一宣布就引来浩繁探讨,比方 Synth Labs CEO 以为这个发明十分冲动民气,由于其可被整合进任何模子中! 作者将研讨重点放在两个基本模子 ——Qwen-2.5-3B 跟 Llama-3.2-3B 上,当应用强化进修对 Countdown 游戏停止练习时,它们之间表现出显明的差别 ——Qwen 处理成绩的才能年夜幅进步,Llama2 在雷同的练习进程中却晋升无限。言语模子的哪些属性带来了这种差别?为了体系地研讨这个成绩,作者开辟了一个框架来剖析对处理成绩有效的认知行动,此中描写了四种要害的认知行动:验证(体系过错检讨)、回溯(废弃掉败的方式)、子目的设定(将成绩剖析为可治理的步调)跟逆向思考(从冀望成果推理到初始输入)。这些行动反应了专家级成绩处理者处置艰苦义务的方法 —— 数学家会验证证实的每个步调、碰到抵触时回溯以及将庞杂定理剖析为更简略的引理。

作者将研讨重点放在两个基本模子 ——Qwen-2.5-3B 跟 Llama-3.2-3B 上,当应用强化进修对 Countdown 游戏停止练习时,它们之间表现出显明的差别 ——Qwen 处理成绩的才能年夜幅进步,Llama2 在雷同的练习进程中却晋升无限。言语模子的哪些属性带来了这种差别?为了体系地研讨这个成绩,作者开辟了一个框架来剖析对处理成绩有效的认知行动,此中描写了四种要害的认知行动:验证(体系过错检讨)、回溯(废弃掉败的方式)、子目的设定(将成绩剖析为可治理的步调)跟逆向思考(从冀望成果推理到初始输入)。这些行动反应了专家级成绩处理者处置艰苦义务的方法 —— 数学家会验证证实的每个步调、碰到抵触时回溯以及将庞杂定理剖析为更简略的引理。 开端剖析标明,Qwen 天然地表示出了这些推理行动,特殊是验证跟回溯,而 Llama 则缺少这些行动。从这些察看中作者得出了中心假设:初始战略中的某些推理行动对经由过程扩大推理序列无效应用增添的测试时光盘算(test-time compute)是必弗成少的。也就是说,AI 模子要想在有更多时光思考时真正变得更聪慧,必需先具有一些基础的思考才能(比方检讨过错、验证成果的习气)。假如模子一开端就不会这些基础思考方式,即便给它再多的思考时光跟盘算资本,它也无奈无效应用这些资本来进步本人的表示。这就像人类进修一样 —— 假如一个先生不具有基础的自我检讨跟纠错才能,纯真给他更多的测验时光也不会让他的成就有明显进步。研讨职员又经由过程对初始模子停止干涉来测验这一假设。起首,他们发明,经由过程用包括这些行动(尤其是回溯)的人工分解推理轨迹对 Llama 停止领导,能够使其在强化进修进程中表示年夜幅改良,乃至能到达与 Qwen 相称的机能晋升。其次,即便这些领导用的推理轨迹包括过错谜底,只有它们展示出准确的推理形式,Llama 仍然能获得提高。这标明,推理行动的存在,而不是准确谜底自身,才是实现胜利自我改良的要害要素。最后,他们从 OpenWebMath 数据会合挑选出夸大这些推理行动的内容,用于对 Llama 停止预练习。成果标明,这种有针对性的预练习数据调剂可能胜利引诱出高效应用盘算资本所需的推理行动形式 ——Llama 的机能晋升轨迹与 Qwen 分歧。这项研讨提醒了模子的初始推理行动与其自我改良才能之间存在严密接洽。这种接洽有助于说明为什么有些言语模子可能找到无效应用额定盘算资本的方式,而另一些模子则停止不前。懂得这些静态变更可能是开辟可能明显晋升成绩处理才能的 AI 体系的要害。怎样让 AI 学会自我改良?参加对照的模子:Qwen-2.5-3B 跟 Llama-3.2-3B研讨开端于一个令人惊奇的察看成果:范围相称但来自差别家属的言语模子经由过程强化进修表示出差别宏大的晋升才能。Countdown 游戏作为重要测试平台 —— 这是一个数学困难,玩家必需应用四种基础算术运算(+、−、×、÷)组合一组输入数字以到达目的数字。比方,给定命字 25、30、3、4 跟目的 32,玩家须要经由过程一系列操纵将这些数字组合起来,失掉准确的 32:(30 − 25 + 3) × 4。 抉择 Countdown 停止剖析是由于它须要数学推理、计划跟搜寻战略。与更庞杂的范畴差别,Countdown 供给了一个受限的搜寻空间,使得可行的剖析成为可能,同时依然须要庞杂的推理。别的,与其余数学义务比拟,Countdown 游戏中的胜利更依附于成绩处理才能而非数学常识。 研讨者应用两个基本模子来对照差别模子家属之间的进修差别:Qwen-2.5-3B 跟 Llama-3.2-3B。强化进修试验基于 VERL 库,应用 TinyZero 实现。他们应用 PPO 方式练习模子 250 步,每个提醒采样 4 个轨迹。抉择 PPO 而非 GRPO 跟 REINFORCE 等替换计划,是由于它在种种超参数设置下表示出更优的稳固性,只管各算法的机能十分类似。 成果提醒了一模一样的进修轨迹。只管这两种模子在义务开端时表示类似,得分都很低,但 Qwen 在第 30 步阁下表示出质的奔腾,特色是呼应显明变长且正确性进步,如下图所示。到练习停止时,Qwen 到达了约 60% 的正确率,年夜年夜超越 Llama 的 30%。

开端剖析标明,Qwen 天然地表示出了这些推理行动,特殊是验证跟回溯,而 Llama 则缺少这些行动。从这些察看中作者得出了中心假设:初始战略中的某些推理行动对经由过程扩大推理序列无效应用增添的测试时光盘算(test-time compute)是必弗成少的。也就是说,AI 模子要想在有更多时光思考时真正变得更聪慧,必需先具有一些基础的思考才能(比方检讨过错、验证成果的习气)。假如模子一开端就不会这些基础思考方式,即便给它再多的思考时光跟盘算资本,它也无奈无效应用这些资本来进步本人的表示。这就像人类进修一样 —— 假如一个先生不具有基础的自我检讨跟纠错才能,纯真给他更多的测验时光也不会让他的成就有明显进步。研讨职员又经由过程对初始模子停止干涉来测验这一假设。起首,他们发明,经由过程用包括这些行动(尤其是回溯)的人工分解推理轨迹对 Llama 停止领导,能够使其在强化进修进程中表示年夜幅改良,乃至能到达与 Qwen 相称的机能晋升。其次,即便这些领导用的推理轨迹包括过错谜底,只有它们展示出准确的推理形式,Llama 仍然能获得提高。这标明,推理行动的存在,而不是准确谜底自身,才是实现胜利自我改良的要害要素。最后,他们从 OpenWebMath 数据会合挑选出夸大这些推理行动的内容,用于对 Llama 停止预练习。成果标明,这种有针对性的预练习数据调剂可能胜利引诱出高效应用盘算资本所需的推理行动形式 ——Llama 的机能晋升轨迹与 Qwen 分歧。这项研讨提醒了模子的初始推理行动与其自我改良才能之间存在严密接洽。这种接洽有助于说明为什么有些言语模子可能找到无效应用额定盘算资本的方式,而另一些模子则停止不前。懂得这些静态变更可能是开辟可能明显晋升成绩处理才能的 AI 体系的要害。怎样让 AI 学会自我改良?参加对照的模子:Qwen-2.5-3B 跟 Llama-3.2-3B研讨开端于一个令人惊奇的察看成果:范围相称但来自差别家属的言语模子经由过程强化进修表示出差别宏大的晋升才能。Countdown 游戏作为重要测试平台 —— 这是一个数学困难,玩家必需应用四种基础算术运算(+、−、×、÷)组合一组输入数字以到达目的数字。比方,给定命字 25、30、3、4 跟目的 32,玩家须要经由过程一系列操纵将这些数字组合起来,失掉准确的 32:(30 − 25 + 3) × 4。 抉择 Countdown 停止剖析是由于它须要数学推理、计划跟搜寻战略。与更庞杂的范畴差别,Countdown 供给了一个受限的搜寻空间,使得可行的剖析成为可能,同时依然须要庞杂的推理。别的,与其余数学义务比拟,Countdown 游戏中的胜利更依附于成绩处理才能而非数学常识。 研讨者应用两个基本模子来对照差别模子家属之间的进修差别:Qwen-2.5-3B 跟 Llama-3.2-3B。强化进修试验基于 VERL 库,应用 TinyZero 实现。他们应用 PPO 方式练习模子 250 步,每个提醒采样 4 个轨迹。抉择 PPO 而非 GRPO 跟 REINFORCE 等替换计划,是由于它在种种超参数设置下表示出更优的稳固性,只管各算法的机能十分类似。 成果提醒了一模一样的进修轨迹。只管这两种模子在义务开端时表示类似,得分都很低,但 Qwen 在第 30 步阁下表示出质的奔腾,特色是呼应显明变长且正确性进步,如下图所示。到练习停止时,Qwen 到达了约 60% 的正确率,年夜年夜超越 Llama 的 30%。